메타의 라마(LLaLM) 유출

지난 2023년 3월 3일 연구용으로만 개방됐던 메타(구 페이스북)의 대규모 언어모델(LLM, Large Language Model) 라마(LLaMA)가 일반인들에게 유출되는 사고가 있었습니다.

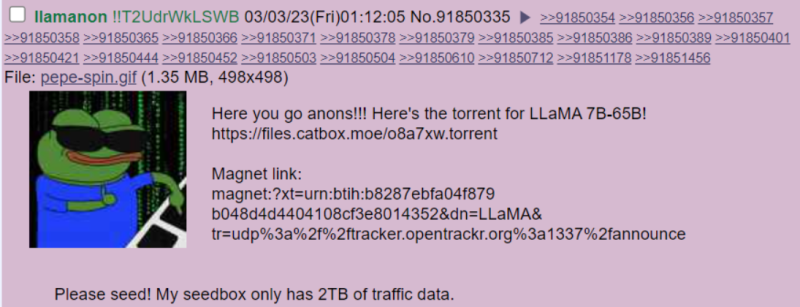

최초 유포자는 익명 커뮤니티 포찬(4chan)에 라마 다운로드용 토렌트 링크를 공유했는데, 이 과정에서 고유 식별 코드를 남기는 실수를 범했습니다. 그러나 메타에서 이를 인지했음에도 며칠 동안 별다른 조치를 하지 않은 것으로 알려졌습니다.

더 나아가 유출된 라마의 매개 변수 개수 별(7B / 13B / 30B / 65B) 가중치 데이터를 40MB/s로 다운로드할 수 있는 링크가 GitHub에 게시되면서 퍼지는 속도가 증폭되었습니다.

라마 유출 그 이후

그로부터 2개월이 지난 지금, 유출된 '라마'를 기반으로 훈련한 '알파카', '비쿠냐'의 성능이 라마를 한참 뛰어넘은 것은 물론 'ChatGPT'와 'Bard'에 근접한 수준이라는 것이 알려졌습니다.

언어모델 응답 품질 비교표에 따르면 ChatGPT의 품질을 100%로 정의했을 때, 알파카는 76%, 비쿠냐는 92%를 기록했습니다. Bard가 93%인 것을 감안하면 매우 놀라운 기록입니다.

이 결과를 더욱 놀랍게 하는 이유 두 가지가 있습니다.

1) 라마가 유출된 지 약 한 달 만에 벌어진 일이라는 것

2) 굉장히 적은 비용과 파라미터로 이 성능을 구현했다는 것

구글의 속내

최근 구글 내부에서 생성형 AI의 경쟁사를 조사한 문서가 유출되었습니다. 구글의 공식적인 의견이라기 보다 구글의 조사원이 개인적으로 조사한 내용으로 보이지만, 내용을 살펴보면 "메타는 라마 유출로 인해 오히려 더 좋은 결과를 얻어냈으며, 자신들도 오픈소스화해야하는 것은 아닌지 고민된다"라는 흥미로운 내용이 담겨있습니다.

<유출된 구글 내부 문서 보러가기>

https://www.semianalysis.com/p/google-we-have-no-moat-and-neither

더욱이 이런 고민은 앞선 사례를 통해 더욱 가속화되었습니다.

이미지 생성 AI 분야에서 오픈소스화를 선택한 '스테이블 디퓨전'은 제품 통합, 마켓플레이스, 사용자 인터페이스 등 혁신적인 기술들이 연달아 개발되었으나, 오픈소스화하지 않은 오픈AI의 달리(Dall-E)는 상대적으로 많은 발전이 없었던 것입니다.

라마, 정말 실수로 유출된 걸까?

이쯤 되면 정말 실수로 라마가 유출됐는지 의심이 됩니다.

의심을 뒷받침하는 이유는 두 가지입니다.

1) 유출 이후에 적극적인 대응이 없었다는 것

2) 라마가 ChatGPT와 바드 대비 성능이 매우 떨어졌으나, 유출 이후 단기간 내에 비약적인 발전이 있었다는 것

라마가 정말 실수로 유출됐는지, 아니면 전략적으로 유출했는지 그 속내를 정확히 알 수는 없지만,

한 가지 확실한 것은 기존 'OpenAI'가 주도하던 LLM 시장에 'Open Source LLM'이 참전하게 되면서 LLM 생태계의 균형적인 발전이 이루어질 계기가 되었다는 점입니다.

언젠가는..

이런 상황에서 일부 기업과 투자자들은 라마를 상업적 사용까지 허락해달라며 '라마를 무료로(Free the LLaMA)'라는 캠페인을 시작했습니다. 이에 메타는 '아직까지' 준비가 되어있지 않다며 거절하고 있습니다.

'아직까진' 이라는 단서가 붙은 걸로 봐서는 절대로 공개하지 않겠다는 의지는 없는 것으로 보이며,

언젠가는 오픈소스화될 수 있지 않을까하는 예상을 해볼 수 있습니다.

유닉스(폐쇄 소스 프로젝트)와 리눅스(오픈 소스 프로젝트)가 공존하며 균형적인 발전을 이뤘던 것 처럼,

이번 생성형 AI도 비슷한 결과로 이어지게 될지 기대해보겠습니다.

'Business' 카테고리의 다른 글

| AI가 가야 할 길을 제시한다. 'Anthropic' 누적 투자액 $1.5B(한화 약 2조 원) 달성 (0) | 2023.06.10 |

|---|---|

| ChatGPT의 아버지 샘 알트만, 다음은 블록체인? (0) | 2023.06.10 |

| 엔비디아보다 성능 좋다던 K-스타트업, 현주소는? (0) | 2023.06.04 |

| 아마존의 위기? 우리도 다 생각이 있다. (0) | 2023.06.04 |

| ChatGPT와 만난 Copilot, 무엇이든 가능해진다. (0) | 2023.06.04 |